Oglas

Če ti voditi spletno stran 10 načinov za ustvarjanje majhnega in preprostega spletnega mesta brez pretiravanjaWordPress je lahko preveč. Kot dokazujejo te druge odlične storitve, WordPress ni vse in konča vse ustvarjanje spletnih strani. Če želite enostavnejše rešitve, lahko izbirate med različnimi. Preberi več , ste verjetno že slišali za datoteko robots.txt (ali »standard za izključitev robotov«). Ne glede na to, ali imate ali ne, je čas, da se o tem poučite, saj je ta preprosta besedilna datoteka ključni del vašega spletnega mesta. Morda se zdi nepomembno, vendar boste morda presenečeni, kako pomembno je.

Oglejmo si, kaj je datoteka robots.txt, kaj počne in kako jo pravilno nastaviti za svoje spletno mesto.

Kaj je datoteka robots.txt?

Če želite razumeti, kako deluje datoteka robots.txt, morate vedeti nekaj o iskalnikih Kako delujejo iskalniki?Za mnoge ljudi je Google internet. To je verjetno najpomembnejši izum od samega interneta. In čeprav so se iskalniki od takrat zelo spremenili, so osnovna načela še vedno enaka. Preberi več

. Kratka različica je, da pošiljajo "pajke", ki so programi, ki brskajo po internetu za informacije. Nato shranijo nekaj teh informacij, da jih lahko pozneje usmerijo k njim.Ti pajki, znani tudi kot »boti« ali »pajki«, najdejo strani z več milijard spletnih mest. Iskalniki jim dajejo navodila, kam naj gredo, vendar lahko posamezna spletna mesta komunicirajo tudi z boti in jim povedo, katere strani naj si ogledajo.

Večino časa dejansko delajo nasprotno in jim povedo, katere strani so ne bi smel gledati. Stvari, kot so skrbniške strani, zaledni portali, strani s kategorijami in oznakami ter druge stvari, ki jih lastniki spletnih mest ne želijo prikazati v iskalnikih. Te strani so še vedno vidne uporabnikom in so dostopne vsem, ki imajo dovoljenje (kar je pogosto vsi).

Toda s tem, ko tem pajkom reče, naj ne indeksirajo nekaterih strani, datoteka robots.txt naredi vsem uslugo. Če bi v iskalniku iskali »MakeUseOf«, bi želeli, da se naše administrativne strani prikažejo visoko na lestvici? Ne. To nikomur ne bi koristilo, zato iskalnikom povemo, naj jih ne prikazujejo. Uporablja se lahko tudi za preprečitev, da bi iskalniki preverili strani, ki jim morda ne pomagajo pri uvrstitvi vašega spletnega mesta v rezultate iskanja.

Skratka, robots.txt pove spletnim pajkom, kaj naj storijo.

Ali lahko pajki prezrejo datoteko robots.txt?

Ali pajki kdaj prezrejo datoteke robots.txt? da. Pravzaprav veliko pajkov narediti ignoriraj. Na splošno pa ti pajki niso iz uglednih iskalnikov. Prihajajo od pošiljateljev neželene pošte, zbiralcev e-pošte in druge vrste avtomatiziranih botov Kako zgraditi osnovni spletni pajek za pridobivanje informacij s spletnega mestaSte kdaj želeli zajeti informacije s spletnega mesta? Tukaj je opisano, kako napisati pajka za krmarjenje po spletnem mestu in izvleči tisto, kar potrebujete. Preberi več ki romajo po internetu. Pomembno je, da to upoštevate – uporaba standarda za izključitev robotov za sporočanje botom, naj se izogibajo, ni učinkovit varnostni ukrep. Pravzaprav bi lahko nekateri roboti začnite s stranmi, na katere jim rečeš, naj ne hodijo.

Iskalniki pa bodo delali tako, kot pravi vaša datoteka robots.txt, če je pravilno formatirana.

Kako napisati datoteko robots.txt

V standardno datoteko za izključitev robota je nekaj različnih delov. Tukaj jih bom razčlenil vsakega posebej.

Izjava uporabniškega agenta

Preden botu poveste, katere strani ne sme gledati, morate določiti, s katerim botom govorite. Večino časa boste uporabili preprosto izjavo, ki pomeni »vsi boti«. To izgleda takole:

Uporabniški agent: *Zvezdica pomeni »vsi boti«. Lahko pa določite strani za določene bote. Če želite to narediti, boste morali poznati ime bota, za katerega postavljate smernice. To bi lahko izgledalo takole:

Uporabniški agent: Googlebot. [seznam strani, ki jih ni treba pajkati] Uporabniški agent: Googlebot-Image/1.0. [seznam strani, ki jih ni treba pajkati] Uporabniški agent: Bingbot. [seznam strani, ki jih ni treba pajkati]In tako naprej. Če odkrijete bota, za katerega sploh ne želite pajkati po vašem spletnem mestu, lahko to tudi določite.

Če želite poiskati imena uporabniških agentov, obiščite useragentstring.com [Ni več na voljo].

Prepoved strani

To je glavni del vaše datoteke za izključitev robota. S preprosto izjavo sporočite botu ali skupini botov, naj ne iščejo po določenih straneh. Sintaksa je enostavna. Tukaj je opisano, kako bi onemogočili dostop do vsega v imeniku »admin« na vašem spletnem mestu:

Onemogoči: /admin/Ta vrstica bi preprečila, da bi boti prešli po vašem spletnem mestu.com/admin, yoursite.com/admin/login, yoursite.com/admin/files/secret.html in vsem, kar spada v skrbniški imenik.

Če želite onemogočiti eno stran, jo navedite v vrstici za onemogočanje:

Prepovedano: /public/exception.htmlZdaj stran »izjeme« ne bo narisana, vse ostalo v »javni« mapi pa bo.

Če želite vključiti več imenikov ali strani, jih navedite v naslednjih vrsticah:

Onemogoči: /zasebno/ Onemogoči: /admin/ Onemogoči: /cgi-bin/ Onemogoči: /temp/Te štiri vrstice bodo veljale za katerega koli uporabniškega agenta, ki ste ga navedli na vrhu razdelka.

Če želite preprečiti, da bi boti pogledali katero koli stran na vašem spletnem mestu, uporabite to:

Onemogoči: /Postavljanje različnih standardov za bote

Kot smo videli zgoraj, lahko določite določene strani za različne bote. Če združimo prejšnja dva elementa, je to videti tako:

Uporabniški agent: googlebot. Onemogoči: /admin/ Disallow: /zasebno/ Uporabniški agent: bingbot. Onemogoči: /admin/ Onemogoči: /zasebno/ Onemogoči: /skrivnost/Razdelka »skrbnik« in »zasebno« bosta nevidna v Googlu in Bingu, vendar bo Google videl »skrivni« imenik, Bing pa ne.

Z uporabo uporabniškega agenta asterisk lahko določite splošna pravila za vse bote, nato pa tudi v naslednjih razdelkih dajte posebna navodila botom.

Vse skupaj

Z zgornjim znanjem lahko napišete celotno datoteko robots.txt. Samo zaženite svoj najljubši urejevalnik besedil (mi smo oboževalci Sublime 11 nasvetov za sublimno besedilo za produktivnost in hitrejši potek delaSublime Text je vsestranski urejevalnik besedil in zlati standard za mnoge programerje. Naši nasveti se osredotočajo na učinkovito kodiranje, vendar bodo splošni uporabniki cenili bližnjice na tipkovnici. Preberi več tukaj) in začnite obveščati bote, da na določenih delih vašega spletnega mesta niso dobrodošli.

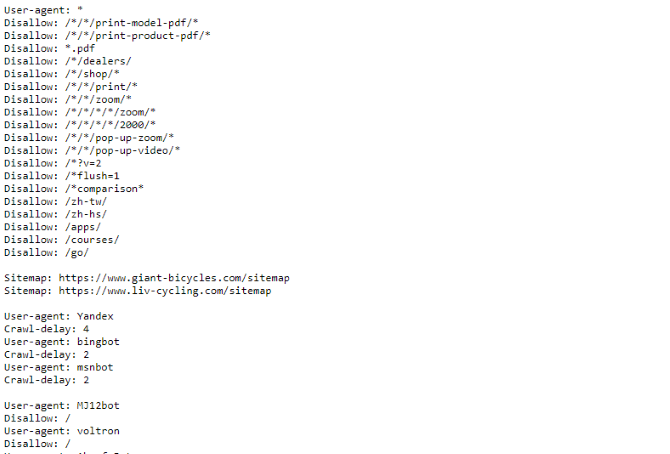

Če želite videti primer datoteke robots.txt, pojdite na katero koli spletno mesto in na konec dodajte »/robots.txt«. Tukaj je del datoteke Giant Bicycles robots.txt:

Kot lahko vidite, obstaja kar nekaj strani, ki jih ne želijo prikazati v iskalnikih. Vključili so tudi nekaj stvari, o katerih še nismo govorili. Oglejmo si, kaj še lahko storite v datoteki za izključitev robota.

Iskanje zemljevida spletnega mesta

Če vaša datoteka robots.txt pove botom, kje ne iti, tvoj zemljevid mesta naredi nasprotno Kako ustvariti zemljevid spletnega mesta XML v 4 preprostih korakihObstajata dve vrsti zemljevidov spletnih mest - stran HTML ali datoteka XML. Zemljevid spletnega mesta HTML je ena stran, ki obiskovalcem prikazuje vse strani na spletnem mestu in običajno vsebuje povezave do teh ... Preberi več , in jim pomaga najti, kar iščejo. In čeprav iskalniki verjetno že vedo, kje je vaš zemljevid spletnega mesta, ne škodi, če jih znova obvestite.

Izjava za lokacijo zemljevida spletnega mesta je preprosta:

Zemljevid spletnega mesta: [URL zemljevida spletnega mesta]to je to.

V naši datoteki robots.txt je videti takole:

Zemljevid spletnega mesta: //www.makeuseof.com/sitemap_index.xmlTo je vse.

Nastavitev zakasnitve pri iskanju

Direktiva o zamudi pri pajkanju določenim iskalnikom pove, kako pogosto lahko indeksirajo stran na vašem spletnem mestu. Meri se v sekundah, čeprav si ga nekateri iskalniki razlagajo nekoliko drugače. Nekateri vidijo zakasnitev pri iskanju 5, kot da jim rečejo, naj počakajo pet sekund po vsakem pajkanju, da začnejo naslednje. Drugi si to razlagajo kot navodilo, da se vsakih pet sekund prebere samo ena stran.

Zakaj bi pajku rekel, naj ne plazi čim več? Za ohrani pasovno širino 4 načini, kako Windows 10 zapravlja vašo internetno pasovno širinoAli Windows 10 zapravlja vašo internetno pasovno širino? Tukaj je opisano, kako to preveriti in kaj lahko storite, da to preprečite. Preberi več . Če vaš strežnik težko sledi prometu, boste morda želeli uvesti zamudo pri pajkanju. Na splošno večini ljudi zaradi tega ni treba skrbeti. Velika spletna mesta z velikim prometom pa bodo morda želeli malo eksperimentirati.

Takole nastavite zakasnitev pri iskanju osem sekund:

Zakasnitev pri plazenju: 8to je to. Vsi iskalniki ne bodo upoštevali vaše direktive. Ampak ne škodi vprašati. Tako kot pri onemogočanju strani lahko nastavite različne zamude pri iskanju po vsebini za določene iskalnike.

Nalaganje vaše datoteke robots.txt

Ko imate vsa navodila v datoteki nastavljena, jo lahko naložite na svoje spletno mesto. Prepričajte se, da je datoteka z navadnim besedilom in ima ime robots.txt. Nato ga naložite na svoje spletno mesto, tako da ga lahko najdete na yoursite.com/robots.txt.

Če uporabljate a sistem za upravljanje vsebin 10 najbolj priljubljenih sistemov za upravljanje vsebin na spletuČasi ročno kodiranih strani HTML in obvladovanja CSS so že davno minili. Namestite sistem za upravljanje vsebin (CMS) in v nekaj minutah lahko imate spletno mesto, ki ga delite s svetom. Preberi več tako kot WordPress, verjetno obstaja poseben način, na katerega boste to morali narediti. Ker se v vsakem sistemu za upravljanje vsebine razlikuje, boste morali prebrati dokumentacijo za svoj sistem.

Nekateri sistemi imajo morda tudi spletne vmesnike za nalaganje vaše datoteke. Za to preprosto kopirajte in prilepite datoteko, ki ste jo ustvarili v prejšnjih korakih.

Ne pozabite posodobiti datoteke

Zadnji nasvet, ki vam ga bom dal, je, da občasno pregledate svojo datoteko za izključitev robota. Vaše spletno mesto se spremeni in morda boste morali narediti nekaj prilagoditev. Če opazite nenavadno spremembo v prometu vašega iskalnika, je dobro, da si ogledate tudi datoteko. Možno je tudi, da bi se lahko standardni zapis v prihodnosti spremenil. Kot vse drugo na vašem spletnem mestu, ga je vredno občasno preveriti.

S katerih strani na svojem spletnem mestu izključujete pajke? Ste opazili kakšno razliko v prometu iskalnikov? Delite svoje nasvete in komentarje spodaj!

Dann je svetovalec za vsebinsko strategijo in trženje, ki podjetjem pomaga ustvariti povpraševanje in potencialne stranke. Prav tako piše o strategiji in trženju vsebin na dannalbright.com.